На этой неделе вы могли видеть заголовки о том, что Samsung Galaxy S23 Ultra делает так называемые «фальшивые» снимки Луны. Начиная с S20 Ultra, у Samsung есть функция Space Zoom, которая сочетает в себе 10-кратный оптический зум с массивным цифровым зумом для достижения комбинированного 100-кратного увеличения. В маркетинговых снимках Samsung показала, что ее телефон делает почти кристально чистые снимки луны, и пользователи сделали то же самое в ясную ночь.

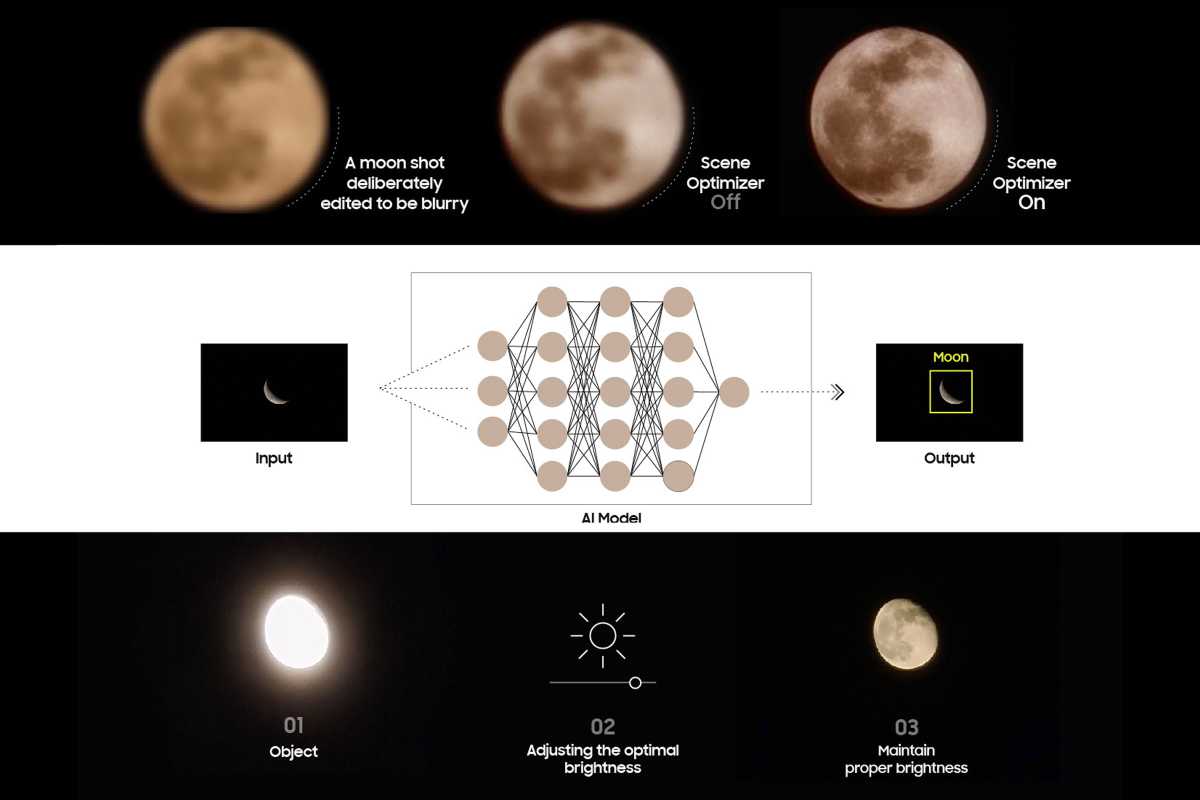

Но Redditor доказал, что невероятный космический зум от Samsung использует немного хитрости. Оказывается, при съемке луны Samsung Scene Optimizer на основе искусственного интеллекта делает много тяжелой работы, чтобы создать впечатление, что луна была сфотографирована с помощью телескопа с высоким разрешением, а не смартфона. Поэтому, когда кто-то делает снимок луны — в небе или на экране компьютера, как в посте на Reddit, — вычислительная машина Samsung берет на себя и очищает кратеры и контуры, которые пропустила камера.

В последующем посте они вне всяких сомнений доказывают, что Samsung действительно добавляет «лунные» изображения к фотографиям, чтобы сделать снимок более четким. Как они объясняют: «Модуль компьютерного зрения/ИИ распознает луну, вы делаете снимок, и в этот момент нейронная сеть, обученная на бесчисленных изображениях луны, заполняет детали, которые не были доступны оптически». Это немного более «фальшиво», чем позволяет себе Samsung, но все же этого следует ожидать.

Даже без следственной работы должно быть совершенно очевидно, что S23 не может естественным образом делать четкие снимки Луны. В то время как Samsung заявляет, что снимки с космическим зумом с использованием S23 Ultra «способны снимать изображения с невероятного расстояния в 330 футов», Луна находится на расстоянии почти 234 000 миль или примерно 1 261 392 000 футов. Это также четверть размера Земли. В конце концов, у смартфонов нет проблем с четкими фотографиями небоскребов, которые находятся на расстоянии более 100 метров.

Конечно, расстояние до Луны не говорит всей истории. Луна — это, по сути, источник света на темном фоне, поэтому камере нужно немного помочь, чтобы получить четкое изображение. Вот как Samsung объясняет это: «Когда вы делаете снимок Луны, система камеры вашего устройства Galaxy будет использовать эту технологию искусственного интеллекта, основанную на глубоком обучении, а также многокадровую обработку для дальнейшего улучшения деталей. Читайте дальше, чтобы узнать больше о многочисленных шагах, процессах и технологиях, необходимых для получения высококачественных изображений Луны».

Это не так уж сильно отличается от таких функций, как «Портретный режим», «Портретное освещение», «Ночной режим», «Волшебный ластик» или «Размытие лица». Все это использует вычислительную осведомленность для добавления, настройки и редактирования вещей, которых нет. В случае с луной искусственному интеллекту Samsung легко создать впечатление, что телефон делает невероятные снимки, потому что искусственный интеллект Samsung знает, как выглядит луна. По той же причине небо иногда кажется слишком голубым, а трава слишком зеленой. Фотодвижок применяет то, что он знает, к тому, что он видит, чтобы имитировать камеру более высокого класса и компенсировать обычные недостатки смартфона.

Разница здесь в том, что, хотя алгоритмы фотосъемки обычно сегментируют изображение на части и применяют к ним различные настройки и элементы управления экспозицией, Samsung также использует ограниченную форму генерации изображений ИИ на луне с деталями, которые никогда не были видны. в данных камеры для начала — но вы этого не узнаете, потому что детали Луны всегда выглядят одинаково, если смотреть с Земли.

Samsung заявляет, что камера S23 Ultra использует «механизм повышения детализации AI на основе глубокого обучения» Scene Optimizer, чтобы эффективно устранять оставшиеся шумы и еще больше улучшать детали изображения.

Samsung

Что будет делать Apple?

Ходят слухи, что Apple впервые в этом году добавит зум-объектив перископа к iPhone 15 Ultra, и это противоречие, несомненно, отразится на том, как компания обучает свой ИИ. Но вы можете быть уверены, что вычислительный движок будет делать изрядное количество тяжелой работы за кулисами, как это делается сейчас.

Вот что делает камеры смартфонов такими замечательными. В отличие от камер типа «наведи и снимай», наши смартфоны обладают мощным «мозгом», который может помочь нам делать более качественные фотографии и улучшить качество плохих фотографий. Это может сделать ночные фотографии такими, как будто они были сделаны при хорошем освещении, и имитировать эффект боке камеры со сверхбыстрой диафрагмой.

И это то, что позволит Apple получить невероятные результаты от 20-кратного или 30-кратного увеличения с 6-кратной оптической камеры. Поскольку Apple до сих пор избегала астрофотографии, я сомневаюсь, что она дойдет до выборки фотографий Луны с более высоким разрешением, чтобы помочь iPhone 15 делать более четкие снимки, но вы можете быть уверены, что его Photonic Engine будет усердно работать, очищая края. , сохраняя детали и расширяя возможности телеобъектива. И судя по тому, что мы получаем в iPhone 14 Pro, результаты наверняка будут впечатляющими.

Будь то Samsung или Apple, вычислительная фотография позволила совершить некоторые из самых больших прорывов за последние несколько лет, и мы только слегка коснулись того, на что она способна. Ничего из этого на самом деле не реально. А если бы это было так, то нас бы меньше впечатляли фотографии, которые мы делаем на наши смартфоны.