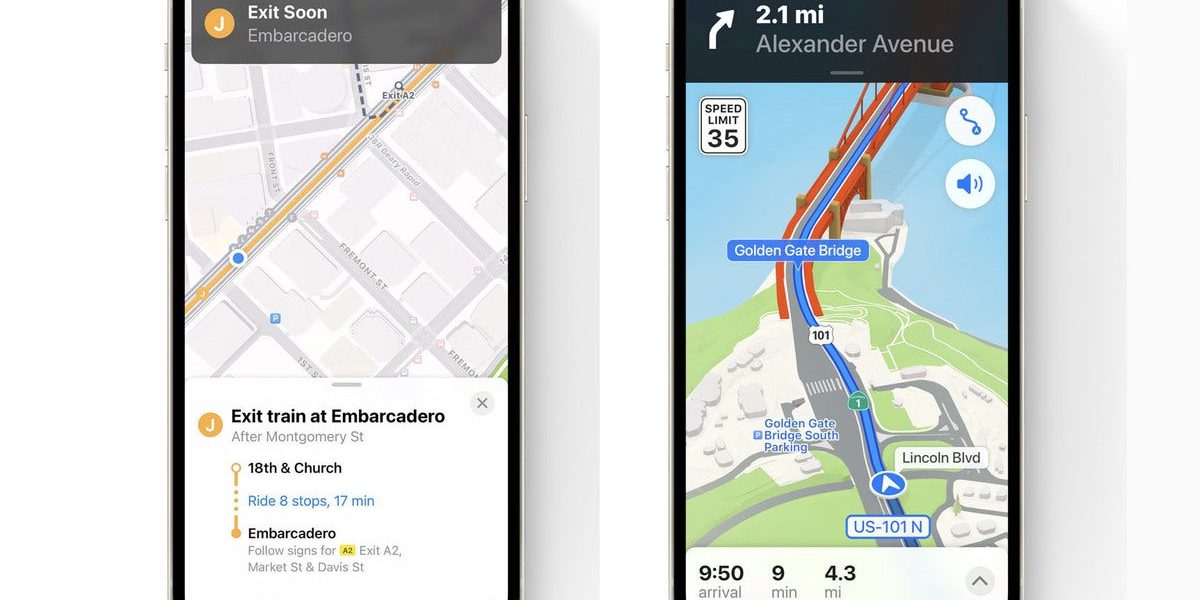

Apple начала выпуск своих давно создаваемых путеводителей по городу с дополненной реальностью (AR), в которых камера и дисплей вашего iPhone показывают, куда вы собираетесь. Он также показывает часть будущего, которое Apple видит для активного использования AR.

В зеркало мы ясно видим

Новое руководство по AR доступно в Лондоне, Лос-Анджелесе, Нью-Йорке и Сан-Франциско. Я не очень уверен, что большинство людей будут чувствовать себя особенно комфортно, раскачивая свои айфоны стоимостью более 1000 долларов в воздухе, путешествуя по туристическим местам. Хотя я уверен, что есть люди, которые действительно надеются на это (и не все они работают в Apple).

Но многие попробуют. Что он делает?

Apple объявила о своем плане ввести пошаговые инструкции по ходьбе в AR, когда анонсировала iOS 15 на WWDC в июне. Идея мощная и работает так:

- Возьмите свой iPhone.

- Направьте его на здания, которые вас окружают.

- iPhone проанализирует предоставленные вами изображения, чтобы определить, где вы находитесь.

- После этого на картах будет сгенерирована высокоточная позиция для предоставления подробных указаний.

Чтобы проиллюстрировать это в Великобритании, Apple выделяет изображение станции Бонд-стрит с большой стрелкой, указывающей направо вдоль Оксфорд-стрит. Слова под этой картинкой сообщают вам, что станция Marble Arch находится всего в 700 метрах.

Это все полезные вещи. Как и многое из того, что делает Apple, он использует ряд небольших инноваций Apple, в частности (но не полностью) Neural Engine в процессорах Apple iPhone серии A. Чтобы распознать то, что видит камера, и указать точное направление, Neural Engine должен использовать множество инструментов машинного обучения, разработанных Apple. К ним относятся API классификации и выравнивания изображений, API обнаружения траектории и, возможно, API распознавания, обнаружения и определения горизонта. Это чистая часть анализа изображений.

Это в сочетании с обнаружением местоположения на устройстве Apple, данными картографии и (я подозреваю) существующей базой данных уличных сцен, чтобы предоставить пользователю почти совершенно точные направления к выбранному пункту назначения .

Это отличная иллюстрация того, чего вы уже можете достичь с помощью машинного обучения на платформах Apple — Cinematic Mode и Live Text — еще два прекрасных недавних примера. Конечно, нетрудно представить, что вы указываете телефоном на уличный знак, используя направления AR таким образом, чтобы получить мгновенный перевод текста.

Джон Джаннандреа, старший вице-президент Apple по машинному обучению, в 2020 году говорил о его важности, когда сказал Ars Technica: «Есть целый ряд новых возможностей, основанных на машинном обучении. И это такие вещи, как языковой перевод, или диктовка на устройстве, или наши новые функции, касающиеся здоровья, такие как сон и мытье рук, и многое другое, что мы выпускали в прошлом для здоровья сердца и тому подобное. Я думаю, что в iOS становится все меньше и меньше мест, где мы не используем машинное обучение ».

Об этом говорят многочисленные технологии камеры Apple. То, что вы можете редактировать изображения в портретном или кинематографическом режиме даже после мероприятия, также иллюстрирует это. Все эти технологии будут работать вместе, чтобы предоставить те возможности Apple Glass, которые, как мы ожидаем, компания начнет выводить на рынок в следующем году.

Но это лишь верхушка того, что возможно, поскольку Apple продолжает расширять количество доступных устройств. обучающие API, которые он предлагает разработчикам. Существующие API-интерфейсы включают следующие, все из которых могут быть дополнены CoreML-совместимыми моделями ИИ:

- API-интерфейсы классификации, выделения, выравнивания и сходства изображений.

- Обнаружение и сопровождение объектов.

- Обнаружение траектории и контура.

- Обнаружение и распознавание текста.

- Обнаружение лиц, отслеживание, ориентиры и качество захвата.

- Обнаружение человеческого тела, поза тела и поза руки.

- Распознавание животных (кошка и собака).

- Штрих-код, прямоугольник, обнаружение горизонта.

- Оптический поток для анализа движения объекта между видеокадрами.

- Сегментация личности.

- Обнаружение документов.

- Семь API естественного языка, включая анализ тональности и языковую идентификацию.

- Распознавание речи и классификация звуков.

Apple регулярно расширяет этот список, но разработчики уже могут использовать множество инструментов для расширения возможностей приложений. В этом небольшом сборнике приложений показаны некоторые идеи. Delta Airlines, которая недавно установила 12 000 iPhone среди сотрудников в полете, также создает приложение AR, чтобы помочь обслуживающему персоналу.

Шаги к инновациям

Мы все думаем, что Apple представит очки AR. в следующем году.

Когда это произойдет, недавно представленные функции Карт от Apple определенно демонстрируют часть ее видения этих вещей. То, что это также дает компании возможность использовать частный анализ на устройстве для сравнения ее собственных существующих коллекций изображений географических мест с изображениями, собранными пользователями, может только помочь ей в разработке все более сложных взаимодействий машинного обучения и изображений.

Мы все знают, что чем больше размер выборки, тем больше вероятность того, что ИИ может дать хорошие, а не мусорные результаты. Если это так, то Apple наверняка должна надеяться убедить свой миллиард пользователей использовать все, что она вводит, для повышения точности систем машинного обучения, которые она использует в Картах. В конце концов, ему нравится строить свою следующую ступеньку на обратной стороне той, которую он сделал раньше.

Кто знает, что ждет нас на этом пути?

Пожалуйста, следуйте за мной на Твиттер или присоединяйтесь ко мне в гриль-баре AppleHolic и дискуссионных группах Apple на MeWe.

Авторские права © 2021 IDG Communications, Inc.